I chip Rubin di Nvidia stanno trasformando l’IA in un’infrastruttura a basso costo. È per questo che i mercati dell’intelligenza aperta come Bittensor iniziano a diventare rilevanti.

Nvidia ha sfruttato il CES 2026 per segnalare un importante cambiamento nel modo in cui funzionerà l’intelligenza artificiale. L’azienda non si è focalizzata sulle GPU per il pubblico consumer, ma ha invece presentato Rubin, una piattaforma di calcolo IA su scala rack progettata per rendere l’inferenza su larga scala più veloce, economica ed efficiente.

Rubin trasforma l’intelligenza artificiale in un’infrastruttura industriale

Il messaggio di Nvidia al CES è stato chiaro: non vende più singoli chip, ma vere e proprie fabbriche di IA.

Rubin rappresenta la piattaforma di data center di nuova generazione di Nvidia, successiva a Blackwell. Integra nuove GPU, memoria HBM4 ad alta velocità, CPU personalizzate e interconnessioni ultra-rapide in un unico sistema altamente integrato.

A differenza delle generazioni precedenti, Rubin considera l’intero rack come un’unica unità di calcolo. Questo design riduce lo spostamento dei dati, migliora l’accesso alla memoria e diminuisce i costi per l’esecuzione di modelli di grandi dimensioni.

Di conseguenza, permette ai fornitori di servizi cloud e alle aziende di eseguire IA con contesti estesi e capacità di ragionamento avanzate a un costo per token molto inferiore.

Questo è importante perché i moderni carichi di lavoro dell’IA non assomigliano più a un singolo chatbot. Sempre più spesso si affidano a una moltitudine di modelli più piccoli, agenti e servizi specializzati che si richiamano tra loro in tempo reale.

Costi più bassi cambiano il modo in cui viene sviluppata l’intelligenza artificiale

Rendendo l’inferenza più economica e scalabile, Rubin apre la strada a una nuova economia dell’IA. Gli sviluppatori possono implementare migliaia di modelli ottimizzati invece di un unico grande monolite.

Le aziende possono eseguire sistemi basati su agenti che utilizzano modelli diversi per compiti differenti.

Tuttavia, ciò genera un nuovo problema. Quando l’IA diventa modulare e abbondante, qualcuno deve decidere quale modello gestisce ciascuna richiesta. Qualcuno deve misurare le prestazioni, gestire la fiducia e instradare i pagamenti.

Le piattaforme cloud possono ospitare i modelli, ma non offrono marketplace neutrali per questi ultimi.

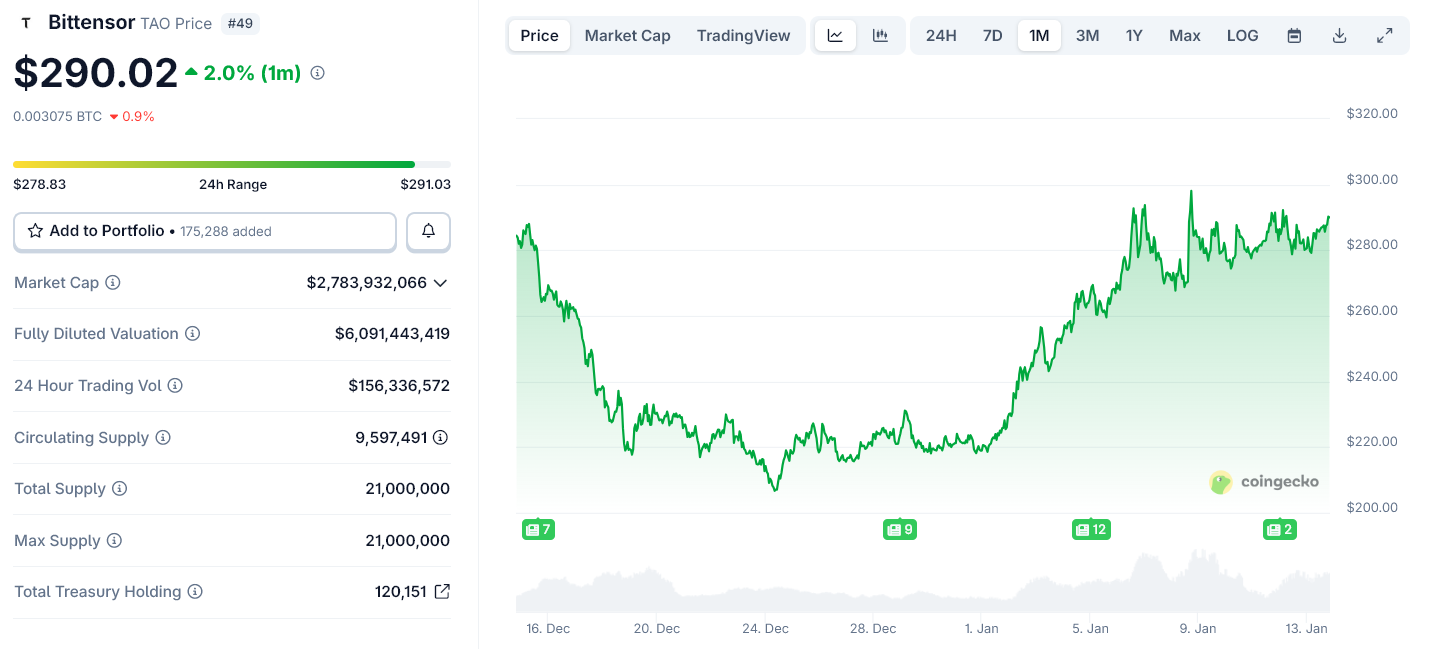

È proprio in quella lacuna che si inserisce Bittensor

Bittensor non vende potenza di calcolo. Gestisce una rete decentralizzata in cui i modelli di IA competono per fornire output utili. La rete classifica questi modelli tramite dati di performance on-chain e li remunera con il proprio token nativo, TAO.

Ogni subnet di Bittensor funziona come un mercato per una specifica tipologia di intelligenza, come generazione di testo, elaborazione di immagini o analisi dati. I modelli che ottengono buoni risultati guadagnano di più. Quelli che registrano prestazioni insufficienti perdono influenza.

Questa struttura diventa sempre più preziosa man mano che cresce il numero dei modelli.

Perché Rubin di Nvidia rende il modello di Bittensor redditizio

Rubin non è in competizione con Bittensor. Rende il modello economico di Bittensor operativo su larga scala.

Man mano che Nvidia abbassa i costi per l’esecuzione dell’IA, più sviluppatori e aziende possono implementare modelli specializzati. Questo aumenta la necessità di un sistema neutrale per classificare, selezionare e remunerare tali modelli tra diverse cloud e organizzazioni.

Bittensor fornisce proprio questo livello di coordinamento. Trasforma la moltitudine di servizi IA in un mercato aperto e competitivo.

Nvidia gestisce il livello fisico dell’IA: chip, memoria e reti. Rubin rafforza questo controllo rendendo l’esecuzione dell’IA più economica e veloce.

Bittensor opera un livello più in alto. Si occupa dell’economia dell’intelligenza scegliendo quali modelli vengono utilizzati e ricompensati.

Via via che l’IA evolve verso swarm di agenti e sistemi modulari, tale livello economico diventa sempre più difficile da centralizzare.

Il lancio di Rubin, previsto per la fine del 2026, espanderà la capacità dell’IA nei data center e sulle cloud. Ciò stimolerà la crescita del numero di modelli e agenti che competono per carichi di lavoro reali.

Le reti open come Bittensor sono pronte a trarre vantaggio da questo cambiamento. Non sostituiscono l’infrastruttura di Nvidia, ma le danno un mercato.

In questo senso, Rubin non indebolisce l’IA decentralizzata. Le fornisce qualcosa da organizzare.