Lo screenshot di un server Discord dedicato al chatbot di intelligenza artificiale (AI) di Google, Bard, suggerisce che alcuni dipendenti di Google mettono in dubbio l’utilità dei chatbot con grandi modelli linguistici (LLM).

I chatbot AI sono diventati di uso comune nel 2023 grazie a ChatGPT di OpenAI e a Bard di Google. Tuttavia, i chatbot AI, allo stato attuale, sono davvero utili?

SponsoredL’esperienza di Google Bard porta a chiedersi se i LLM stiano facendo la differenza

Secondo Bloomberg, esiste un server Discord dedicato ai grandi utenti di Google Bard e ad alcuni dipendenti del gigante dei motori di ricerca. In questo server si discute dell’efficacia e dell’utilità del chatbot.

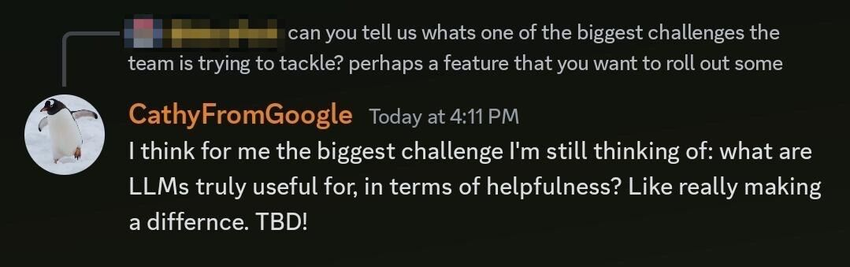

Bloomberg ha raccolto gli screenshot delle conversazioni di due membri del server Discord da luglio a ottobre. In agosto, Cathy Pearl, responsabile dell’esperienza utente di Google Bard, ha scritto:

Sponsored“La sfida più grande a cui sto ancora pensando: per cosa sono veramente utili i LLM, in termini di utilità? Come fare davvero la differenza. TBD!”.

Per saperne di più: I modelli di apprendimento automatico più popolari nel 2023

I membri della comunità ritengono che Bard non sia in grado di rispondere nemmeno alle domande di base. Un utente di X (Twitter) ha scritto:

“Chiunque abbia usato Bard probabilmente sarà d’accordo. Non è nemmeno in grado di rispondere alle domande di base sul funzionamento delle applicazioni di Google, ad esempio Analytics, reCAPTCHA ecc. Andate a provarlo”.

Il Product Manager di Google ritiene che l’output non possa essere attendibile

Si è discusso sull’affidabilità dei dati generati dai chatbot. Dominik Rabiej, product manager di Bard, sostiene che i LLM non sono in una fase in cui gli utenti possono fidarsi dei loro risultati senza verificarli in modo indipendente. Ha affermato che:

“La mia regola generale è di non fidarmi dei risultati degli LLM se non posso verificarli in modo indipendente”.

Gli LLM sono modelli di intelligenza artificiale addestrati con un’ampia serie di dati per generare risultati simili a quelli umani. Chatbot come ChatGPT e quello di Google utilizzano gli LLM.

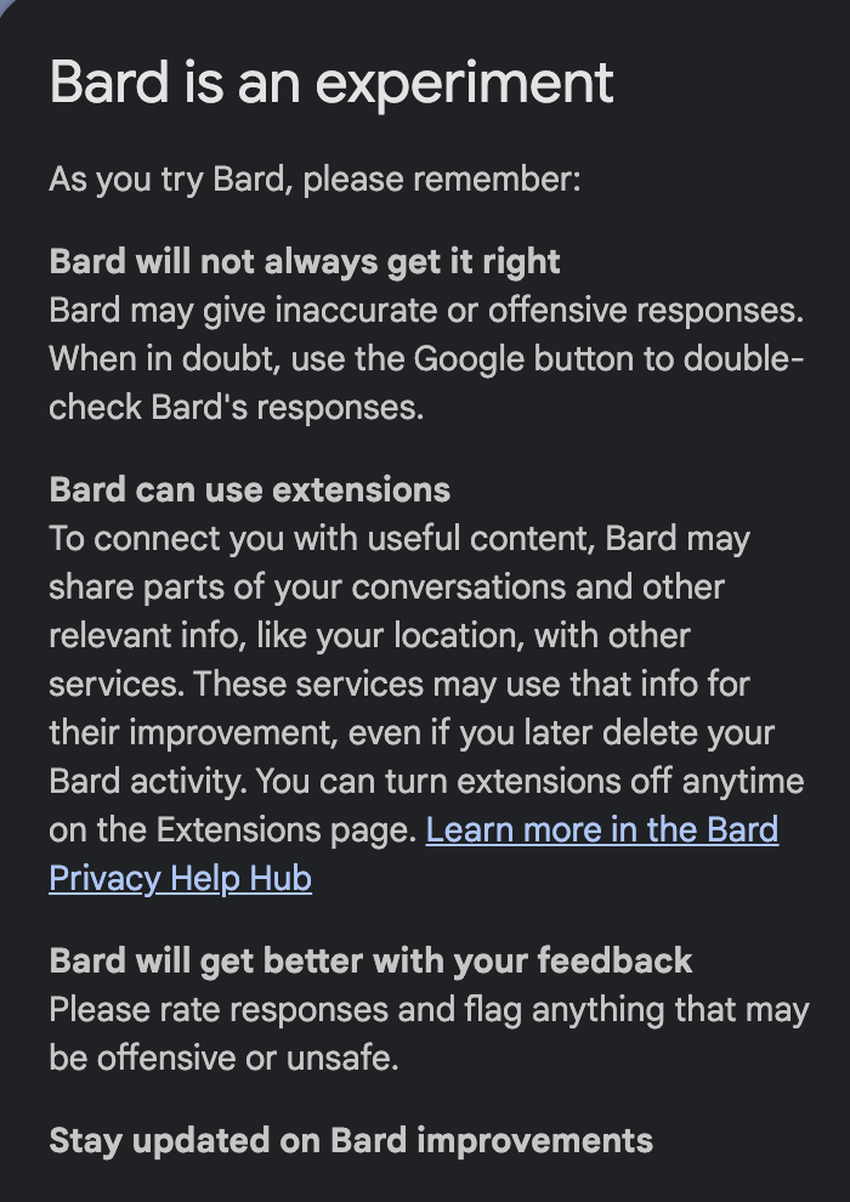

Poiché i dati non sono completamente affidabili, Rabiej suggerisce che l’ideale è usare Google Bard per fare brainstorming, invece di affidarsi a lui solo per le informazioni. Infatti, quando un utente inizia a usare Bard, appare un messaggio che dice: “è un esperimento”. Il messaggio recita inoltre:

“Bard non sarà sempre corretto Bard potrebbe dare risposte imprecise o offensive. In caso di dubbio, utilizzare il pulsante Google per ricontrollare le risposte di Bard”.

Per saperne di più: ChatGPT vs. Google Bard: Un confronto tra chatbot AI

Avete qualcosa da dire sul chatbot di Google o su qualsiasi altra cosa? Scriveteci o partecipate alla discussione sul nostro canale Telegram. Potete trovarci anche su TikTok, Facebook o X (Twitter).

Per le ultime analisi di BeInCrypto sulBitcoin (BTC), cliccate qui.