Il Gruppo dei Sette (G7) è pronto a stabilire un “Codice di condotta” volontario per le aziende che innovano nel campo dei sistemi avanzati di intelligenza artificiale (AI). Questa iniziativa, scaturita dal “processo di Hiroshima sull’IA”, cerca di affrontare il potenziale usoimproprio e i rischi associati a questa tecnologia trasformativa.

Il G7, composto da Canada, Francia, Germania, Italia, Giappone, Gran Bretagna e Stati Uniti, insieme all’Unione Europea, ha avviato questo processo per creare un precedente per l’amministrazione dell’IA.

Il G7 lancia il Codice di condotta globale per l’IA

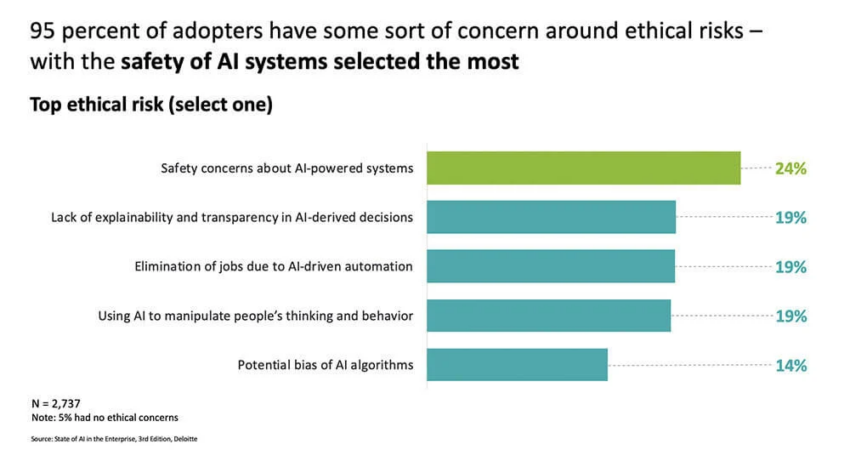

Tra le crescenti preoccupazioni per la privacy e i rischi per la sicurezza, il codice in 11 punti è un faro di speranza. Secondo un documento del G7, il codice di condotta,

“mira a promuovere un’IA sicura, protetta e affidabile in tutto il mondo e fornirà una guida volontaria per le azioni delle organizzazioni che sviluppano i sistemi di IA più avanzati”.

Il codice incoraggia le aziende a identificare, valutare e mitigare i rischi durante l’intero ciclo di vita dell’IA. Inoltre, raccomanda di riportare pubblicamente le capacità, le limitazioni e l’utilizzo dell’IA, sottolineando i solidi controlli di sicurezza.

Per saperne di più: I 6 lavori più caldi nel campo dell’intelligenza artificiale (AI) nel 2023

Il capo della Commissione europea per il digitale Vera Jourova, in occasione di un forum sull’amministrazione di Internet, ha dichiarato,

“Un Codice di condotta è una base solida per garantire la sicurezza e fungerà da ponte fino all’introduzione di una regolamentazione”.

OpenAI si unisce alla causa

Anche OpenAI, la società madre di ChatGPT, ha formato un team di preparazione per gestire i rischi posti dai modelli di IA. Guidato da Aleksander Madry, il team si occuperà di rischi quali la persuasione personalizzata, le minacce alla sicurezza informatica e la propagazione della disinformazione.

Questa iniziativa è il contributo di OpenAI all’imminente summit britannico sull’IA, che fa eco alla richiesta globale di sicurezza e trasparenza nello sviluppo dell’IA.

L’amministrazione britannica definisce l’IA di frontiera come,

“Modelli di IA di uso generale altamente capaci, in grado di svolgere un’ampia varietà di compiti e di eguagliare o superare le capacità presenti nei modelli più avanzati di oggi”.

Il team Preparedness di OpenAI si concentrerà sulla gestione dei rischi, rafforzando ulteriormente la necessità di un “Codice di condotta” globale per l’IA.

Con la continua evoluzione dell’IA, la posizione proattiva del G7 e l’impegno di OpenAI nella mitigazione dei rischi sono risposte tempestive. Il “Codice di condotta” volontario e la formazione di un gruppo di preparazione dedicato rappresentano passi significativi verso lo sfruttamento responsabile del potere dell’IA. L’obiettivo è garantire che i suoi benefici siano massimizzati e che i rischi potenziali siano gestiti in modo efficace.

Dichiarazione di non responsabilità

In conformità alle linee guida del Trust Project, BeInCrypto si impegna a riportare notizie imparziali e trasparenti. Questo articolo mira a fornire informazioni accurate e tempestive. Tuttavia, si consiglia ai lettori di verificare i fatti in modo indipendente e di consultare un professionista prima di prendere qualsiasi decisione basata su questi contenuti.

Questo articolo è stato inizialmente compilato da un’intelligenza artificiale avanzata, progettata per estrarre, analizzare e organizzare le informazioni da un’ampia gamma di fonti. Opera senza credenze personali, emozioni o nonobiettivi, fornendo contenuti incentrati sui dati. Per garantire la pertinenza, l’accuratezza e l’aderenza agli standard editoriali di BeInCrypto, un redattore umano ha meticolosamente rivisto, modificato e approvato l’articolo per la pubblicazione.

Dichiarazione di non responsabilità

Tutte le informazioni contenute nel nostro sito web sono pubblicate in buona fede e solo a scopo informativo generale. Qualsiasi azione intrapresa dal lettore in base alle informazioni contenute nel nostro sito web è strettamente a suo rischio e pericolo.