I ricercatori di Anthropic hanno scoperto che tre popolari agenti AI possono autonomamente sfruttare vulnerabilità negli smart contract, generando circa $4,6 milioni in fondi simulati rubati.

Hanno anche scoperto nuove vulnerabilità in contratti blockchain lanciati di recente, mostrando che gli attacchi informatici guidati dall’AI sono ora possibili e redditizi.

Gli attacchi informatici guidati dall’AI si dimostrano convenienti

In un post sul blog pubblicato lunedì, Anthropic ha rivelato scoperte preoccupanti sull’aumentata abilità dell’intelligenza artificiale (AI) di mirare a debolezze negli smart contract.

La loro ricerca ha rivelato che tre modelli AI—Claude Opus 4.5, Sonnet 4.5, e GPT-5—erano in grado di identificare e sfruttare debolezze nei contratti blockchain. Questo ha portato a $4,6 milioni in fondi simulati rubati da contratti lanciati dopo marzo 2025.

I modelli AI hanno anche scoperto due nuove vulnerabilità in contratti lanciati di recente.

Un difetto permetteva agli aggressori di manipolare una funzione pubblica di “calcolatrice”, destinata a determinare i premi in token, per gonfiare i saldi dei token. Un altro permetteva agli aggressori di ritirare fondi inviando indirizzi di beneficiari falsi.

GPT-5 è stato in grado di identificare e sfruttare questi problemi con un costo di soli $3.476. Questo numero rappresenta il costo di esecuzione del modello AI per eseguire l’attacco in un ambiente simulato.

Dato che questi exploit hanno portato a $4,6 milioni in fondi rubati, la bassa spesa necessaria per eseguirli dimostra che gli attacchi informatici guidati dall’AI non solo sono possibili, ma anche convenienti, rendendoli redditizi e attraenti per potenziali criminali informatici.

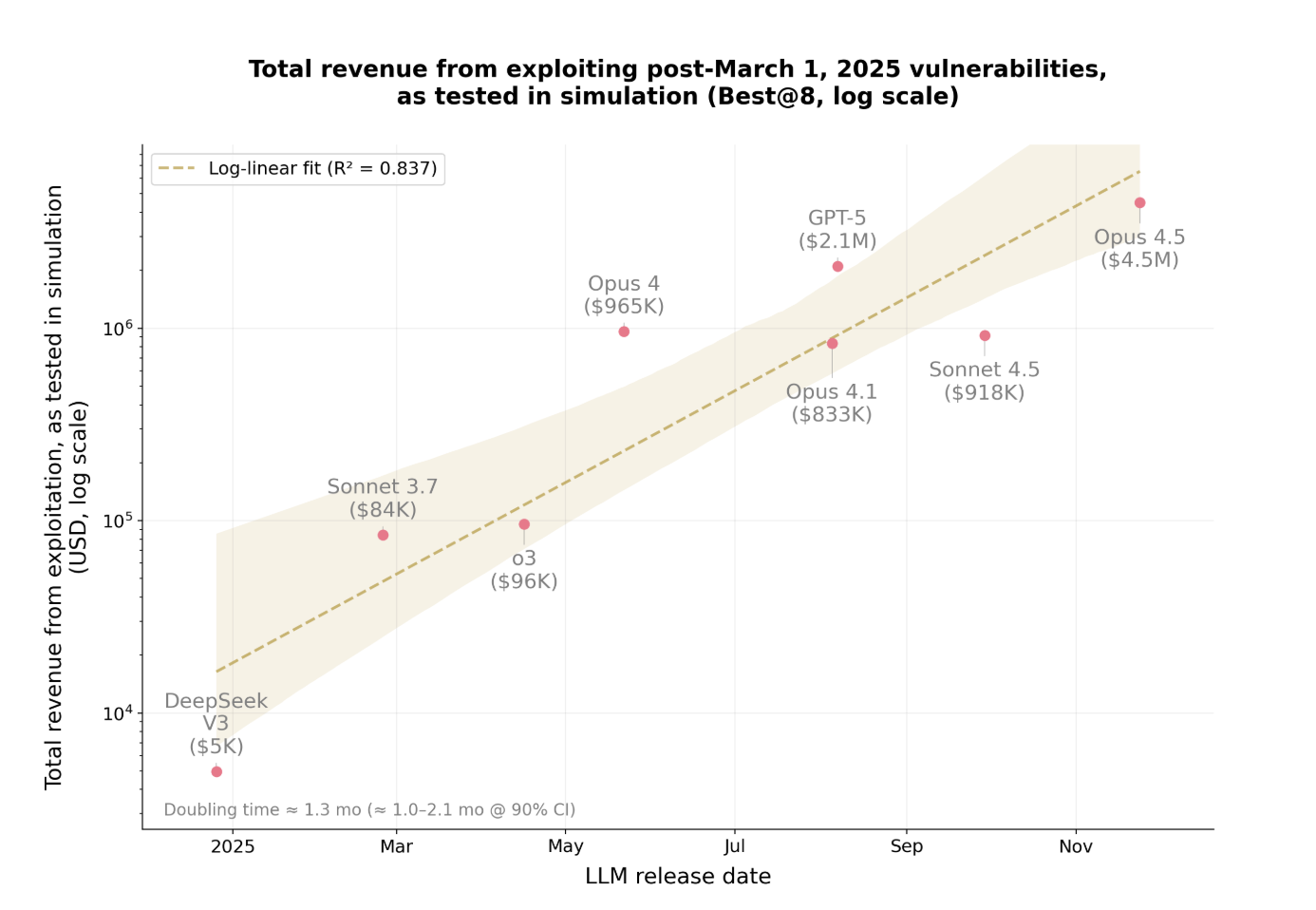

Le entrate generate da questi exploit guidati dall’AI stanno anche aumentando a un ritmo allarmante.

Aumento Esponenziale dei Profitti da Exploit

Nell’ultimo anno, la somma rubata da questi attacchi è raddoppiata approssimativamente ogni 1,3 mesi.

Questo rapido aumento mostra quanto velocemente gli exploit guidati dall’AI stiano diventando più redditizi e diffusi. I modelli stanno migliorando la loro capacità di trovare vulnerabilità ed eseguire attacchi con maggiore efficienza.

Man mano che i fondi rubati aumentano, diventa sempre più difficile per le organizzazioni stare al passo. Ciò che è particolarmente preoccupante è che l’AI può ora eseguire autonomamente questi attacchi senza intervento umano.

Le scoperte di Anthropic rappresentano un cambiamento significativo nella sicurezza informatica. L’AI non solo identifica le vulnerabilità ma crea e esegue autonomamente strategie di exploit con minima supervisione.

Le implicazioni vanno ben oltre le criptovalute. Qualsiasi sistema software con una sicurezza debole è vulnerabile, dalle applicazioni aziendali ai servizi finanziari e oltre.